Kundenservice: Tel +43.1.97000-100 • kundenservice@forum-media.at

Diese Website setzt ausschließlich technisch notwendige Cookies und Cookies zur allgemeinen Reichweitenmessung ein, um die Funktionalität und eine gute Benutzererfahrung zu gewährleisten. Diese werden ausschließlich von uns verwendet und die Daten werden nicht an Dritte weitergegeben. Detaillierte Infos: Datenschutzrichtlinie

© WEKA Business Solutions GmbH

A-1200 Wien, Dresdner Straße 45

E-Mail: kundenservice@forum-media.at

drucken

12.05.2025 | Datenschutz & IT | ID: 1198282

Generative KI eröffnet Sicherheitsfachkräften neue Wege, um Aufgaben im Arbeitsalltag schneller und strukturierter zu bewältigen. Beispielsweise kann KISicherheitsfachkräfte bei folgenden Aufgaben unterstützen:

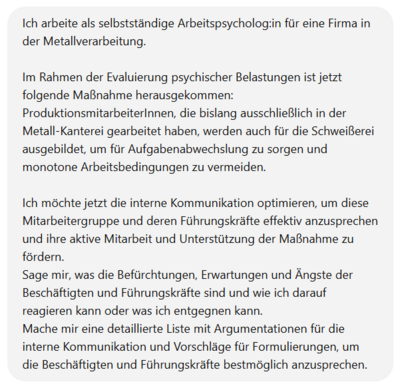

Damit künstliche Intelligenz optimale Ergebnisse liefert, sind effektive Prompts erforderlich. Unter diesen Prompts versteht man Eingaben in die KI, die vom System verarbeitet werden. Ein bewährtes Hilfsmittel für die Erstellung von Prompts ist das SOAR-Modell. Wenn Prompts in dieser Art erstellt werden, sind präzisere und besser nutzbare Ergebnisse aus der KI das Ergebnis. Das SOAR-Modell eignet sich deshalb besonders gut für komplexe und situationsspezifische Fragestellungen. Das SOAR-Modell besteht aus 4 Aspekten:

Beispiel für einen Prompt nach dem SOAR-Modell:

Für Tätigkeiten, die regelmäßig anfallen oder spezielles Fachwissen erfordern, bieten so genannte CustomGPTs eine besonders effiziente Unterstützung. Dabei handelt es sich um maßgeschneiderte KI-Anwendungen, die – anders als der allgemeine ChatGPT – exakt auf bestimmte Anforderungen, Fachbereiche oder Abläufe angepasst sind.

Diese spezialisierten KI-Tools können so eingerichtet werden, dass sie typische Formulierungen, Begrifflichkeiten einer Organisation und Sprachstil einer Person übernehmen. Dadurch agieren sie besonders passgenau – sei es im unternehmensspezifischen Kontext oder für individuelle Arbeitsschwerpunkte.

Ein wesentliches Risiko beim Einsatz generativer KI-Modelle wie ChatGPT besteht darin, dass sie – sofern nicht gezielt eingegrenzt – dazu neigen, Inhalte zu erfinden. Dieses Phänomen wird auch als „Halluzinieren“ bezeichnet.

Dabei formuliert die KI teils sehr überzeugend Fachinformationen oder nennt Quellen und Studien, die bei genauerer Überprüfung gar nicht existieren. Gerade im sicherheitsrelevanten Kontext ist daher Vorsicht geboten – jede automatisierte Aussage sollte überprüft werden, bevor sie weiterverwendet wird.

Zur Vermeidung dieses Risikos eignen sich folgende Tipps:

Mit dem EU AI Act gibt es nun klare Vorgaben für Transparenz, Nachvollziehbarkeit und den Schutz sensibler Daten. Sicherheitsfachkräfte müssen sicherstellen, dass sie KI-Tools datenschutzkonform einsetzen, insbesondere wenn personenbezogene oder betriebsinterne Informationen verarbeitet werden.

Prüfen Sie daher immer vor dem Einsatz die Datenschutzeinstellungen Ihres KI-Tools und lassen Sie mit Ihren Daten nicht das KI-Modell verbessern.

Firmen sollten für den KI-Einsatz klare Spielregeln vorgeben und die nach dem EU-AI-Act verpflichtenden KI-Schulungen ernst nehmen.